企業リリース Powered by PR TIMES

PR TIMESが提供するプレスリリースをそのまま掲載しています。内容に関する質問 は直接発表元にお問い合わせください。また、リリースの掲載については、PR TIMESまでお問い合わせください。

(2020/5/15)

カテゴリ:商品サービス

リリース発行企業:NVIDIA

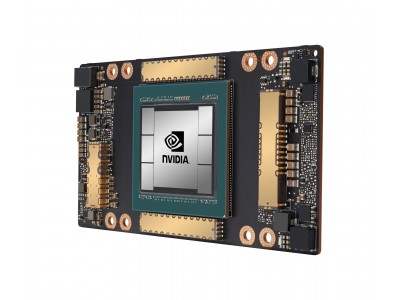

新しい NVIDIA A100 GPU により AI の学習と推論が最大 20 倍高速化、

NVIDIA 初のエラスティックなマルチインスタンス GPU がデータ アナリティクス、学習および推論を

一元処理、世界の主要クラウド プロバイダーやサーバー メーカーが採用

2020 年 5 月 14 日、カリフォルニア州サンタクララ — GTC 2020 — NVIDIA は本日、NVIDIA(R) Ampere

アーキテクチャをベースとした初の GPU である NVIDIA A100 の生産が本格化され、全世界のお客様に出荷

中であることを発表しました。

A100 は NVIDIA Ampere アーキテクチャの画期的なデザインを採用しており、NVIDIA の全 8 世代の GPU

のなかで最大の性能向上を遂げています。A100 は AI の学習と推論を一元処理し、前世代に比べて最大20 倍の性能向上を実現しています。汎用的なワークロード アクセラレーターである A100 は、データ アナリティクスやサイエンティフィック コンピューティング、クラウド グラフィックスといった用途も想定して作られています。

NVIDIA の創業者/CEO であるジェンスン フアン (Jensen Huang) は、次のように述べています。「クラウドコンピューティングと AI の強力なトレンドは、データセンターの設計に構造的な転換をもたらしています。かつてはCPU のみのサーバーで溢れていたものが、今では GPU アクセラレーテッド コンピューティングになっています。NVIDIA A100 GPU は AI 性能を 20 倍に飛躍させ、データアナリティクスから学習、推論まで、エンドツーエンドの機械学習を加速します。NVIDIA A100 はスループットを向上し、同時にデータセンターの費用削減を実現します。」

A100 に組み込まれている新しいエラスティック コンピューティング テクノロジにより、あらゆる処理に適切な規模の演算能力を提供できるようになります。マルチインスタンス GPU 機能により、各 A100 GPU を最大 7 つの独立したインスタンスに分割して推論タスクを処理できるようになり、さらに第 3 世代 NVIDIA NVLink(R) インターコネクト テクノロジにより、複数の A100 GPU を単一の巨大な GPU として動作させることで、これまで以上に大規模な学習タスクに対応できるようにもなります。

世界の主要クラウド プロバイダーやシステム ビルダーが、A100 GPU を自社の製品やサービスに採用する予定

です。それらのなかには、Alibaba Cloud や Amazon Web Services (AWS)、Atos, Baidu Cloud、Cisco、

Dell Technologies、富士通、GIGABYTE、Google Cloud、H3C、Hewlett Packard Enterprise (HPE)、

Inspur、Lenovo、Microsoft Azure、Oracle、Quanta/QCT、Supermicro、Tencent Cloud などが含まれ

ています。

全世界で即座に採用

NVIDIA A100 GPU のパワーを採用する企業のなかには Microsoft も含まれており、同社は A100 の性能と

スケーラビリティを活用する予定です。

Microsoft Corp. のコーポレート バイスプレジデントであるミハイル パラキン (Mikhail Parakhin) 氏は、次の

ように話しています。「Microsoft は、現行世代の NVIDIA GPU を積極的に活用して、世界最大の言語モデ

ルである Turing Natural Language Generation を学習してきました。NVIDIA の新世代の A100 GPU を

使用すれば、Azure ではるかに大規模な AI モデルを学習できるようになり、言語、音声、ビジョンおよびマルチ

モダリティの可能性がさらに押し広げられるでしょう。」

DoorDash はオンデマンドのフード プラットフォームを供給しており、パンデミックの最中での飲食業界のライフラインとなっています。同社は AI インフラストラクチャが柔軟性を持つことの重要性に注目しています。

DoorDash の機械学習エンジニアであるゲイリー レン (Gary Ren) 氏は、次のように話しています。「大量のデ

ータを要求する今日の複雑な AI の学習や推論のワークロードは、モデルの学習時間の削減や、機械学習の開発プロセスのスピード向上などの点において、NVIDIA A100 GPU のような最先端のテクノロジから恩恵を受けることができます。さらに、クラウドベースの GPU クラスタを使用することで、必要に応じてスケール アップやスケール ダウンが可能な柔軟性が生まれ、効率性の向上、運用の簡略化、そしてコストの削減などに貢献することが新たにわかりました。」

その他のアーリー アダプターには、国立研究所やいくつかの世界最高レベルの教育機関および研究機関が含まれており、それぞれが A100 を使って次世代スーパーコンピューターに利用しようとしています。それらの機関には、以下が含まれています。

● 米国のインディアナ大学では、HPE の Cray Shasta システムをベースにした Big Red 200 スーパーコンピューターによって、科学や医学の研究、ならびに人工知能、機械学習およびデータ アナリティクスでの先進的な研究を支援しようとしています。

● ドイツのユーリッヒ スーパーコンピューティング センターにある、Atos が構築した JUWELS ブースター

システムは、究極の演算能力と人工知能タスクのために設計されています。

● ドイツのカールスルーエ工科大学では、Lenovo とともに HoreKa スーパーコンピューターを構築しており、材料科学、地球システム科学、エネルギーとモビリティの研究のための工学、素粒子と天体素粒

子物理学の分野において、きわめて大規模な、マルチスケール シミュレーションを行おうとしています。

● ドイツのマックス プランク コンピューティング/データ施設では、Lenovo が構築した次世代のスーパーコンピューターである Raven を活用して、マックス プランク研究所にハイパフォーマンス コンピューティング アプリケーションの開発、最適化、解析およびビジュアライゼーションのためのハイレベルなサポートを提供しています。

● ローレンス バークレー国立研究所にある米国エネルギー省管轄国立エネルギー研究科学計算センターでは、HPE の Cray Shasta システムをベースにして、次世代スーパーコンピューターのPerlmutter を構築し、エクストリームスケール科学を支援し、新エネルギー源の開発、エネルギー効率の改善、ならびに新素材の発見などを目的としています。

A100 の 5 つのブレイクスルー

NVIDIA A100 GPU は、以下のような 5 つの主要なイノベーションにより、技術的デザインのブレイクスルーを実現しています:

● NVIDIA Ampere アーキテクチャ — A100 の核となるのは、NVIDIA Ampere GPU アーキテクチャです。540 億以上のトランジスターで構成されており、世界で最もトランジスターの集積密度が高い 7nm プロセスのプロセッサです。

● TF32 に対応した第 3 世代 Tensor コア — 広く採用されている NVIDIA の Tensor コアが、より柔軟に、より速く、より使いやすくなっています。強化された機能のなかには、AI 向け TF32 が含まれています。これにより、コードを変更することなく FP32 の精度を維持しながら AI 性能を最大で 20 倍向上させることができます。また、Tensor コアが FP64 に対応し、前世代の HPC アプリケーションに比べて、演算能力が最大で 2.5 倍向上しています。

● マルチインスタンス GPU (MIG) — 新しい技術的特徴である MIG により、単一の A100 GPU を最大 7 つの GPU に分割することができます。これにより、規模の異なるさまざまな処理に合わせて演算能力を提供することができ、利用率が最適化され、投資効果を最大化できます。

● 第 3 世代 NVIDIA NVLink — 2 倍速くなった GPU 間の高速接続により、サーバー内で性能を効率的にスケーリングできます。

● 構造的疎性 — この新しい効率化技術は、AI 数学が本来持っているスパースな性質を利用して性能を倍増させます。

これらの新機能により、NVIDIA A100 は AI の学習と推論だけでなく、科学シミュレーション、会話型 AI、レコメンデーション システム、ゲノミクス、ハイパフォーマンス データ アナリティクス、地震モデリングおよび金融予測といった、多様で要件の厳しいワークロードに最適な GPU です。

NVIDIA A100 が新たなシステムで利用可能になり、クラウドでの利用もまもなく可能に

本発表と共に発表された NVIDIA DGX A100TM システムには、NVIDIA NVLink で相互接続された 8 基の

NVIDIA A100 GPU が搭載されています。このシステムは、NVIDIA および認定パートナーより間もなく提供が

開始されます。

Alibaba Cloud、AWS、Baidu Cloud、Google Cloud、Microsoft Azure、Oracle および Tencent Cloudでは、A100 を活用したサービスを計画しています。

また、A100 をベースにした多様なサーバーが、Atos や Cisco、 Dell Technologies、富士通、GIGABYTE、

H3C、HPE、Inspur、Lenovo、Quanta/QCT、Supermicro といった、世界の大手システム メーカーより発売

される予定です。

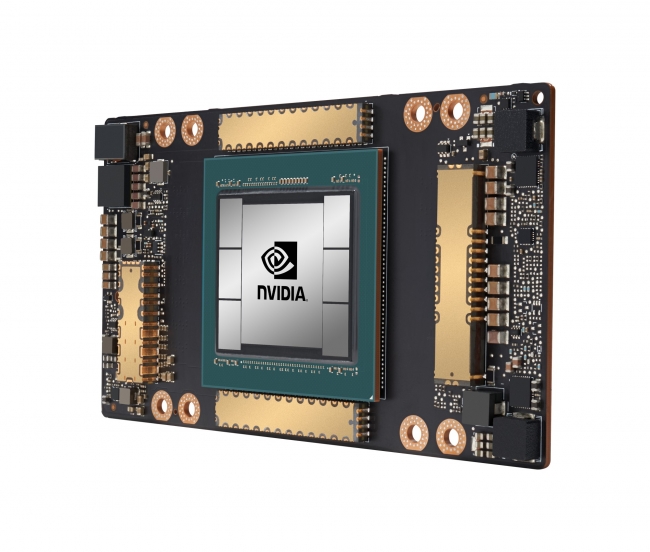

パートナーのサーバー開発を加速させるために、NVIDIA は複数の GPU 構成で統合されたベースボード形式のサーバー ビルディング ブロックである HGX A100 を作成しました。

4 GPU の HGX A100 では、NVLink によってすべての GPU が相互接続され、8 GPU 構成では、NVIDIA

NVSwitchTM を通じてすべての GPU が全帯域幅で接続されます。新しいマルチインスタンス GPU アーキテク

チャを実装した HGX A100 は、それぞれが NVIDIA T4 より高速な 56 個の小型 GPU という構成から、10

PFLOPS の AI 性能を持つ、巨大な 8 GPU サーバーにまでのあらゆる構成を組むことができます。

A100 向けの NVIDIA ソフトウェアの最適化

NVIDIA は、アプリケーション開発者が A100 のイノベーションを活用できるようにするために、ソフトウェア スタックのいくつかのアップデートも発表しました。このアップデートには、グラフィックス、シミュレーションおよび AI を高速化するために使用される 50 以上の CUDA-XTM ライブラリ、CUDA 11、マルチモーダルな対話型 AI サービスのフレームワークである NVIDIA Jarvis、ディープラーニング レコメンデーション アプリケーション フレームワークのNVIDIA Merlin、ならびに HPC 開発者が A100 用のコードのデバッグおよび最適化を行うためのコンパイラ、ライブラリおよびツールで構成された NVIDIA HPC SDK の新バージョンが含まれています。

NVIDIA について

1999 年における NVIDIA (NASDAQ 表示: NVDA)による GPU の発明は、PC ゲーミング市場の成長に爆発

的な拍車をかけ、現代のコンピュータ グラフィックスを再定義し、並列コンピューティングに革命的変化を起こしました。最近では、GPU ディープラーニングが最新の AI (次世代コンピューティング) に火をつけ、世界を知覚し理解することができるコンピュータ、ロボット、自律走行車の脳として GPU は機能しています。詳細は、こちらのリンクから: www.nvidia.co.jp/

企業プレスリリース詳細へ

PRTIMESトップへ

※ ニュースリリースに記載された製品の価格、仕様、サービス内容などは発表日現在のものです。その後予告なしに変更されることがありますので、あらかじめご了承下さい。