企業リリース Powered by PR TIMES

PR TIMESが提供するプレスリリースをそのまま掲載しています。内容に関する質問 は直接発表元にお問い合わせください。また、リリースの掲載については、PR TIMESまでお問い合わせください。

(2021/4/22)

カテゴリ:商品サービス

リリース発行企業:NVIDIA

NVIDIA AI プラットフォームが、データ センターからエッジまで、すべての MLPerf カテゴリで記録を更新

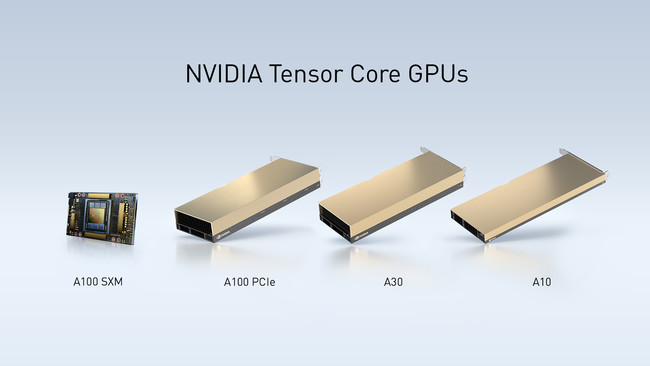

2021 年 4 月 21 日 カリフォルニア州サンタクララ — NVIDIA は本日、メインストリーム サーバー用 GPU である NVIDIA(R) A30 GPUおよび A10 GPU が新たに追加された NVIDIA の AI 推論プラットフォームが、MLPerf の最新ラウンドにおけるすべてのカテゴリで記録的なパフォーマンスを達成したことを発表しました。

MLPerf は、コンピューター ビジョン、医用画像、レコメンダー システム、音声認識、自然言語処理といったさまざまなワークロードにわたって AI パフォーマンスを測定する、業界標準のベンチマークです。

今回初めて MLPerf に登場した NVIDIA A30 GPUおよび A10 GPU は、高いパフォーマンスと低消費電力を兼ね備え、AI 推論、トレーニング、グラフィックス、および従来のエンタープライズ向けのコンピューティング ワークロードに至るまで、幅広いメインストリームのオプションを企業に提供します。Cisco、Dell Technologies、Hewlett Packard Enterprise、InspurおよびLenovoが今夏より、大量に出荷されている自社のサーバーにこれらの GPU を搭載する予定です。

NVIDIA は今回の成果を達成するにあたり、さまざまな GPU や TensorRT™ や NVIDIA Triton™ Inference Server といった AI ソフトウェアで構成される NVIDIA AI プラットフォームをフル活用しました。TensorRT™ や NVIDIA Triton™ Inference Serverは Microsoft、Pinterest、 Postmates、 T-Mobile、 USPS や WeChat といった大手企業にすでに採用されています。

NVIDIA のアクセラレーテッド コンピューティング部門ゼネラル マネージャー兼バイス プレジデントであるイアン バック (Ian Buck) は次のように述べています。「AI があらゆる業界に変革をもたらし続ける中、MLPerf は、企業が IT インフラストラクチャへの投資において情報に基づく決定を下すために、その重要性がますます高まってきています。今や大手 OEM はすべて MLPerf の結果を提出しており、NVIDIA とパートナーが目下注力しているのは、世界をリードする性能を AI にもたらすことに留まらず、新しい A30 GPU および A10 GPU を搭載したエンタープライズ向けサーバーの波によって AI を民主化することです。」

MLPerf の結果

NVIDIA はデータセンターおよびエッジ カテゴリにおけるすべてのテストについて結果を提出している唯一の企業であり、MLPerf のすべてのワークロードにおいてトップの性能を達成しています。

また、Triton Inference Server を使用した結果も複数提出しています。Triton Inference Server は、主要なフレームワークのモデルをすべてサポートし、GPU だけでなく CPU でも実行でき、バッチ、リアルタイム、ストリーミングといったさまざまなクエリ タイプに最適化できるため、AI をアプリケーションに展開する際の複雑さを軽減します。今回 Triton の結果を提出したことで、GPU 実装および CPU 実装における最高の最適化に近いパフォーマンスを、同等の構成で達成しました。

NVIDIA はまた、NVIDIA Ampere アーキテクチャのMulti-Instance GPU (以下MIG)機能を使用した結果を提出したことで新境地を開拓しました。7 つの MIG インスタンスを使用する単一の GPU で 7 つの MLPerf オフライン テストすべてを同時に実行したのです。この構成でも、単一の MIG インスタンスで実行された結果と比較してほぼ同じ性能が観測されました。

こうした結果を提出したことで MIG のパフォーマンスと汎用性が実証され、インフラストラクチャの管理者は特定のアプリケーションに適切なサイズの GPU コンピューティングをプロビジョニングして、データセンターのすべての GPU から最大の出力を引き出せるようなります。

NVIDIAからの提出だけでなく、富士通株式会社、Alibaba Cloud、 Dell Technologies、 GIGABYTE、 HPE、 Inspur、 Lenovoおよび Supermicroといった NVIDIAの パートナーからも NVIDIA GPU を使用したテスト結果が360以上提出されました。

拡大し続けるNVIDIA のAI プラットフォーム

NVIDIA A30 GPU および A10 GPU は、NVIDIA AI プラットフォームに追加された最新製品です。NVIDIA AI プラットフォームには他にも、NVIDIA Ampere アーキテクチャ GPU、NVIDIA Jetson™ AGX Xavier、Jetson Xavier NX、ならびに AI を高速化するために最適化された NVIDIA ソフトウェアのフルスタックが備わっています。

A30 は、業界標準のサーバーに多様なパフォーマンスを提供し、レコメンダー システム、対話型 AI、コンピューター ビジョンなど、AI 推論やメインストリームのエンタープライズ向けコンピューティング ワークロードを幅広くサポートしています。

NVIDIA A10 GPUはディープラーニング推論、インタラクティブ レンダリング、コンピューター支援設計 (CAD)、クラウド ゲーミングなどを高速化し、企業は共通のインフラストラクチャで AI とグラフィックスの混合ワークロードに対応できるようになります。NVIDIA 仮想 GPU ソフトウェアを使用することで管理が合理化され、設計者、エンジニア、アーティスト、科学者が使用する仮想デスクトップの使用率やプロビジョニングが改善されます。

NVIDIA Jetson プラットフォームは NVIDIA Xavier™ System-on-Module をベースとしており、サーバークラスの AI パフォーマンスをエッジに提供し、ロボティクス、ヘルスケア、小売、スマート シティといったさまざまな分野での利用が可能です。NVIDIA の統合アーキテクチャと CUDA-X™ ソフトウェア スタックで構築された Jetson は、コンパクトな設計ですべてのエッジ ワークロードを、消費電力 30W 未満で実行できる唯一のプラットフォームです。

提供状況

NVIDIA A100 GPU は、大手メーカーのサーバーと、すべての主要クラウド サービス プロバイダーのクラウドで利用できます。また、A100 GPU は NVIDIA DGX Station A100、NVIDIA DGX A100、NVIDIA DGX SuperPOD など、NVIDIA DGX™ システム ポートフォリオ全体に搭載されています。

消費電力がわずか165WのA30、 および150Wの A10 は、幅広いワークロードに高いパフォーマンスを提供するために厳格なテストを経た NVIDIA-Certified Systems™ などのさまざまなサーバーへの搭載が今夏より予定されています。

Jetson AGX Xavier および Jetson Xavier NX System-on-Module は、世界中の販売代理店から現在提供中です。

NVIDIA Triton と NVIDIA TensorRT はどちらも、NVIDIA のソフトウェア カタログである NGC™ より入手可能です。

企業プレスリリース詳細へ

PRTIMESトップへ

※ ニュースリリースに記載された製品の価格、仕様、サービス内容などは発表日現在のものです。その後予告なしに変更されることがありますので、あらかじめご了承下さい。