企業リリース Powered by PR TIMES

PR TIMESが提供するプレスリリースをそのまま掲載しています。内容に関する質問 は直接発表元にお問い合わせください。また、リリースの掲載については、PR TIMESまでお問い合わせください。

(2023/3/22)

カテゴリ:商品サービス

リリース発行企業:NVIDIA

ジェネレーティブ AI のトレーニングと推論の急増する需要に対応するためNVIDIA H100 がクラウド大手から提供開始。Meta、OpenAI、Stability AI が H100 を 活用して AI の次の波へ

カリフォルニア州サンタクララ — GTC — 2023 年 3 月 21 日 — NVIDIA と主要パートナーは本日、ジェネレーティブ AI のトレーニングと推論に対し急速に高まる需要に対応するため、世界で最も強力な AI 向け GPUである NVIDIA H100 Tensor コア GPU(https://www.nvidia.com/ja-jp/data-center/h100/ ) を搭載した新しい製品とサービスの提供を発表しました。

Oracle Cloud Infrastructure (OCI)(https://blogs.oracle.com/cloud-infrastructure/post/limited-availability-oci-compute-nvidia-h100 )は、H100 GPU を搭載した新しい OCI Compute ベアメタル GPU インスタンスを限定提供すると発表しました。さらに、Amazon Web Services は、相互接続された H100 GPU を最大 2 万基まで拡張できる Amazon EC2 P5 インスタンスの EC2 UltraClusters を発表しました。これは、Microsoft Azure (https://azure.microsoft.com/en-us/blog/azure-previews-powerful-and-scalable-virtual-machine-to-help-customers-accelerate-ai/ )が先週発表した H100 仮想マシン ND H100 v5 のプライベート プレビューに続くものです。

さらに、Meta は現在、H100 を搭載した Grand Teton AI スーパーコンピューターを AI のプロダクションおよび研究チームのために社内で展開しています。

NVIDIA の創業者/CEO であるジェンスン フアン (Jensen Huang) は、本日の GTC 基調講演で NVIDIA DGX H100 AI スーパーコンピューターがフル生産に入っており、世界中の企業に間もなく納入されることを発表しました。

ジェンスン フアンは次のように述べています。「ジェネレーティブ AI の驚異的な可能性は、事実上すべての業界に、ビジネス戦略とそれを達成する上で必要なテクノロジを再考するよう促しています。NVIDIA とそのパートナー各社は、私たちの生活、仕事、遊び方を根本的に変えるアプリケーションを構築する人々に、世界で最も強力な AI コンピューティング プラットフォームを一刻も早く提供できるように動いています」

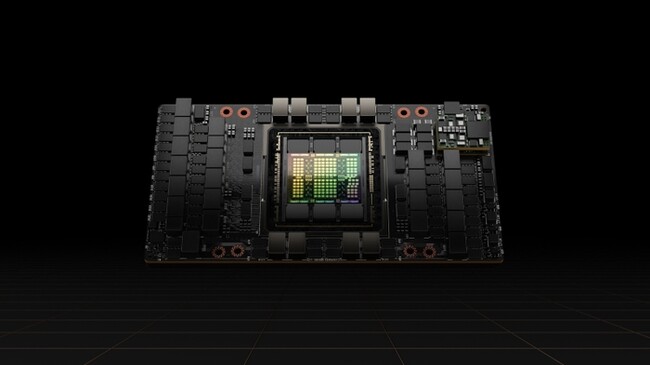

Hopper アーキテクチャが AI を加速

H100 は、Transformer Engine を内蔵した NVIDIA Hopper™ GPU コンピューティング アーキテクチャをベースとしており、ジェネレーティブ AI、大規模言語モデル (LLM)、およびレコメンダー システムの開発、トレーニング、展開に最適化されています。このテクノロジは、H100 の FP8 精度を利用し、前世代の A100 と比較して、LLM で 9 倍高速な AI トレーニングと最大 30 倍高速な AI 推論を提供します。H100 は、世界中のメーカーから個別および厳選されたボード ユニットで秋に出荷を開始しました。

NVIDIA DGX™ H100 は、NVIDIA NVLink(R) 高速インターコネクトで接続された 8 基の H100 GPU を備え、NVIDIA Quantum InfiniBand および Spectrum™ イーサネット ネットワークを統合しています。このプラットフォームは、FP8 の精度で 32 ペタフロップスのコンピューティング パフォーマンスと、前世代よりも 2 倍高速なネットワークを提供し、大規模な AI ワークロードを処理する際のエネルギー効率を最大化します。

DGX H100 は、完全な NVIDIA AI ソフトウェア スタックも備えているため、企業は大規模な AI ワークロードをシームレスに実行および管理できます。このソフトウェア スタックには、本日別途発表された(https://developer.nvidia.com/blog/supercharging-production-ai-everywhere-with-ai-enterprise-3-1/ ) NVIDIA AI Enterprise (https://www.nvidia.com/ja-jp/data-center/products/ai-enterprise/ )の最新バージョンに加え、DGX データ センターのオペレーティング システムである NVIDIA Base Command™(https://www.nvidia.com/ja-jp/data-center/base-command/ ) が含まれており、NVIDIA DGX プラットフォーム全体で AI のトレーニングと運用を調整して AI 開発を簡素化および効率化します。

AI のパイオニアが H100 を採用

ジェネレーティブ AI におけるパイオニアの数社が、作業を加速するため H100 を採用しています。

● OpenAIは、H100 の前世代の GPU である NVIDIA A100 GPU を使用して、対話に最適化された AI システムである ChatGPT のトレーニングと実行を行い、記録的な速さで世界中の数億人に利用されるようになりました。OpenAI は今後、Azure スーパーコンピューター上で H100 を使用し、継続的な AI 研究を推進する予定です。

● NVIDIA の主要なテクノロジ パートナーである Meta (https://blogs.nvidia.com/blog/2022/10/18/meta-grand-teton/ )は、Hopper ベースの AI スーパーコンピューターである Grand Teton システムを開発し、前システムの Zion と比べてホストから GPU への帯域幅を 4 倍、コンピューティングとデータのネットワーク帯域幅を 2 倍、パワー エンベロープを 2 倍にするなど、複数倍の性能強化を行いました。このように計算能力が向上した Grand Teton は、ディープラーニングのレコメンダー モデルやコンテンツ理解のトレーニングと実運用の推論の両方をサポートすることができます。

● テキストから画像を生成する AI のパイオニアである Stability AI は、AWS の H100 の早期アクセスの顧客です。Stability AI は、H100 を使用して、今後のビデオ、3D、およびマルチモーダル モデルを高速化する予定です。

● 企業や開発者がマルチモーダルなビデオ理解にアクセスできるプラットフォームを提供する Twelve Labs は、OCI Supercluster 上の H100 インスタンスを使用して、ビデオを瞬時に、インテリジェントに、簡単に検索できるようにすることを計画しています。

● Anlatan は、AI 支援によるストーリー作成とテキストから画像への合成を行う NovelAI アプリのクリエーターであり、モデルの作成と推論のために CoreWeave のクラウド プラットフォームで H100 インスタンスを使用しています。

世界中の DGX H100

以下を含む世界中のイノベーターが、DGX H100 システムの最初の波に乗っています。

● 日本を拠点とするデジタル広告とインターネット サービスのリーディング カンパニーであるサイバーエージェントは、ジェネレーティブ AIと LLM テクノロジをフル活用し、著名人のデジタル ツインや、AIで生成されたデジタル広告を制作しています。

● 米国最大の大学付属研究センターであるジョンズ ホプキンス大学応用物理研究所(https://www.jhuapl.edu/about ) は、LLM のトレーニングに DGX H100 を使用しています。

● KTH 王立工科大学 (ストックホルムに本拠を置くヨーロッパの主要な技術および工学大学) は、DGX H100 を使用して、高等教育向けの最先端のコンピューター サイエンス プログラムを提供しています。

● エネルギー、ウェルネス事業、ICT 事業などの分野で多種多様な事業を多角的に展開する三井物産(https://blogs.nvidia.co.jp/2023/03/22/generative-ai-supercomputer-pharmaceutical-industry/ )は、DGX H100 を搭載した創薬向けのスーパーコンピューターを構築しています。

● エクアドルの主要な電気通信プロバイダーである Telconet は、安全な都市のためのインテリジェント ビデオ解析と、スペイン語の方言全体で顧客をサポートする言語サービスを構築しています。

エコシステムのサポート

「私たちは AI イノベーションと AI ファーストの製品に全力を注いでいます。NVIDIA H100 GPU は最先端の機械学習アクセラレーターであり、モデルのトレーニングからモデルの推論まで幅広いアプリケーションで、機械学習業界内で顕著な優位性をもたらしています」 - Atlanan – Anlatan CEO、Eren Doğan 氏

「AWS とNVIDIA は、大規模でコスト効率の高い GPU ベースのソリューションをオンデマンドで提供するために、12 年以上にわたって協業してきました。AWS は、世代を重ねるごとにスケーラビリティの限界を超える GPU ベースのインスタンスを提供してきた豊富な経験を有しています。現在、多くのお客様が機械学習トレーニングのワークロードを 1 万基以上の GPU に拡張しています。第 2 世代の EFA では、P5 インスタンスを 2 万基以上の H100 GPU に拡張することができ、あらゆる組織にオンデマンドのスーパーコンピュータ機能をもたらします」 - AWS – Amazon EC2 バイス プレジデント、David Brown 氏

「AIは、Google Cloudで行うすべてのことの中核をなすものです。NVIDIA H100 GPUとその強力な機能は、当社の業界をリードするAI製品およびサービスと相まって、お客様が新たな地平を切り開くことを可能にします。私たちは、NVIDIAと協力して、企業がジェネレーティブAIの力を活用する取り組みを加速させることができることを嬉しく思います。」 - Google Cloud - システム&サービス インフラストラクチャ担当バイスプレジデント、Amin Vahdat氏

「ジェネレーティブ AI に基づくような、AI を活用した新しい体験を構築するにつれ、基盤となるAIモデルはますます高度化していきます。Meta の最新の H100 搭載 Grand Teton AI スーパーコンピューターは、より大きな計算能力、メモリ容量、帯域幅をもたらし、オープンソースの DLRM などの Meta の AI モデルのトレーニングと推論をさらに加速させます。次のコンピューティング プラットフォームに移行するにあたり、H100 は Meta の将来のコンテンツ レコメンデーション、ジェネレーティブ AI、メタバースのニーズを研究するためのより大きなコンピューティング性能も提供します」 - Meta - インフラストラクチャー、AIシステム、アクセラレーテッド プラットフォーム担当バイス プレジデント、Alexis Bjorlin 氏

「AI の採用が加速し続けるにつれて、ビジネスの運営と成功の方法が根本的に変化しています。NVIDIA の Hopper アーキテクチャを Microsoft Azure に導入することで、比類のないコンピューティング パフォーマンスと機能を、AI 機能の拡張を検討している企業に提供できます。」 - Microsoft - Microsoft のクラウド + AI グループのエグゼクティブ バイス プレジデント、Scott Guthrie 氏

「NVIDIA H100 Tensor コア GPU の計算能力は、AI のトレーニングと推論のフロンティアを推進する私たちの取り組みを可能にするために不可欠です。NVIDIA の進歩により、GPT-4 のようなシステムにおける私たちの研究とアライメント作業が可能になります」 - OpenAI – 社長 兼 共同創業者、 Greg Brockman 氏

「OCI は、あらゆる規模の何千もの組織に、スケールアップしたAI スーパーコンピューティング機能を提供しています。NVIDIA との強力なコラボレーションは、お客様に大きな価値を提供しており、H100 のパワーに期待を寄せています」 - Oracle Cloud Infrastructure - CTO兼シニア バイス プレジデント Greg Pavlik 氏

「世界をリードするオープンソースのジェネレーティブ AI モデル企業として、Stability AI は消費者と企業にマルチモーダルな作成のための世界最高のツールを提供することに取り組んでいます。NVIDIA H100 のパワーを活用することで、前例のないコンピューティング パワーが提供され、ジェネレーティブ AI の変革力から利益を得ようと急増する人々の創造性と研究能力が促進されます。これにより、エクサバイトのデータ用の高度な相互接続と高度なアーキテクチャから独自のメリットを得るビデオ、3D、およびその他のモデルを解き放つことができます」 - Stability AI – Stability AI 創業者 兼 CEO、Emad Mostaque 氏

「Twelve Labs は、NVIDIA H100 GPU を搭載した Oracle Cloud Infrastructure Compute ベアメタル インスタンスを活用し、ビデオ基盤モデルの市場投入に向けた取り組みをリードし続けることに期待しています」 - Twelve Labs – CEO、Jae Lee 氏

提供時期

NVIDIA DGX H100 スーパーコンピューターは本格的な生産に入っており、世界中の NVIDIA パートナーから注文できます。顧客は、NVIDIA DGX Cloud (https://www.nvidia.com/en-us/data-center/dgx-cloud/ )で DGX H100 を本日から試用することができます。価格は、世界中の NVIDIA DGX パートナーから入手可能です。

クラウドの NVIDIA H100 は、Azure のプライベート プレビュー、Oracle Cloud Infrastructure の限定提供、Cirrascale (https://cirrascale.com/press-nvidia-h100.php )と CoreWeave(https://www.coreweave.com/blog )の一般提供での利用が可能です。AWS は、H100 を今後数週間のうちに限定プレビューで利用できるようにすると発表しています。Google Cloud は、クラウド パートナーである、Lambda (https://lambdalabs.com/blog/lambda-cloud-adding-nvidia-h100-tensor-core-gpus-in-early-april )、Paperspace (https://blog.paperspace.com/paperspace-launches-support-for-the-new-nvidia-h100-gpu/ )、Vultr と共に、H100 の提供を予定しています。

NVIDIA H100 GPU を搭載したサーバーとシステムは、Atos、Cisco、Dell Technologies、GIGABYTE、Hewlett Packard Enterprise、Lenovo、Supermicro などの主要なサーバー メーカーから入手できます。

価格およびその他の詳細は、NVIDIA パートナーから直接入手できます。

フアンが GTC 基調講演 (https://www.nvidia.com/ja-jp/gtc/?ncid=em-even-559985 )で NVIDIA Hopper アーキテクチャについて述べているのをご覧ください。

企業プレスリリース詳細へ

PRTIMESトップへ

※ ニュースリリースに記載された製品の価格、仕様、サービス内容などは発表日現在のものです。その後予告なしに変更されることがありますので、あらかじめご了承下さい。