企業リリース Powered by PR TIMES

PR TIMESが提供するプレスリリースをそのまま掲載しています。内容に関する質問 は直接発表元にお問い合わせください。また、リリースの掲載については、PR TIMESまでお問い合わせください。

(2023/3/22)

カテゴリ:商品サービス

リリース発行企業:NVIDIA

Google Cloud、D-ID、Cohere がチャットボット、Text-to-Image のコンテンツ、AI ビデオなどを含む幅広いジェネレーティブ AI サービスに新しいプラットフォームを活用

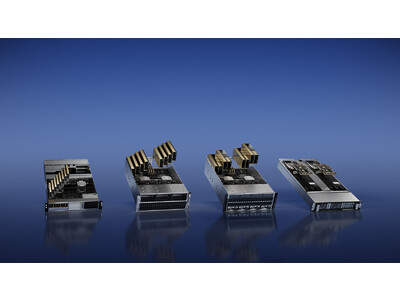

カリフォルニア州サンタクララ — GTC — 2023 年 3 月 21 日 — NVIDIA は本日、急速に台頭しつつある多様なジェネレーティブ AI アプリケーション向けに最適化された 4 つの推論プラットフォームを発表しました。これにより開発者は、新しいサービスと洞察が提供できる、AI を活用したドメイン特有のアプリケーションの迅速な構築が可能となります。

これらのプラットフォームは、本日発売された NVIDIA L4 Tensor コア GPU ( https://www.nvidia.com/en-us/data-center/l4 ) と NVIDIA H100 NVL GPU ( https://www.nvidia.com/ja-jp/data-center/h100/ ) を含む最新の NVIDIA Ada、Hopper、および Grace Hopper プロセッサと、NVIDIA のフル スタックの推論ソフトウェアを組み合わせています。各プラットフォームは、AI ビデオ、画像生成、大規模言語モデルの展開、レコメンダーの推論など、需要の高いワークロード向けに最適化されています。

NVIDIA の創業者/CEO であるジェンスン フアン (Jensen Huang) は以下のように述べています。「ジェネレーティブ AI の台頭により、より強力な推論コンピューティング プラットフォームが必要になっています。ジェネレーティブ AI のアプリケーションの数は無限であり、人間の想像力さえ超えます。 最も強力で柔軟な推論コンピューティング プラットフォームを開発者に提供することで、まだ想像もつかない方法で私たちの生活を改善する新しいサービスの構築が加速されるでしょう」

ジェネレーティブ AI の多様な推論ワークロードを加速

各プラットフォームには、特定のジェネレーティブ AI 推論ワークロード向けに最適化された NVIDIA GPU と専用ソフトウェアが含まれています。

● AI ビデオ用 NVIDIA L4 は、CPU の 120 倍の AI を活用したビデオ パフォーマンスを提供し、エネルギー効率を 99% 向上させます。ほぼすべてのワークロードに対応するユニバーサル GPU として機能し、強化されたビデオのデコードおよびトランスコーディング機能、ビデオ ストリーミング、拡張現実、ジェネレーティブ AI ビデオなどを提供します。

● 画像生成用の NVIDIA L40 は、グラフィックスおよび AI 対応の 2D、ビデオ、および 3D 画像生成用に最適化されています。L40 プラットフォームは、データ センターでメタバース アプリケーションを構築および運用するためのプラットフォームである NVIDIA Omniverse™ ( https://www.nvidia.com/ja-jp/omniverse/ ) のエンジンとして機能し、前世代に比べて 7 倍の Stable Diffusion の推論パフォーマンスと 12 倍の Omniverse パフォーマンスを提供します。

● 大規模言語モデル展開用の NVIDIA H100 NVL は、ChatGPT のような LLM を大規模に展開するのに理想的です。Transformer Engine によるアクセラレーション、94 GB のメモリを備えた新しい H100 NVL は、GPT-3 で前世代の A100 と比較して最大 12 倍高速な推論パフォーマンスをデータ センター規模で提供します。

● レコメンダー モデル用の NVIDIA Grace Hopper は、グラフ レコメンダー モデル、ベクトル データベース、およびグラフ ニューラル ネットワークに最適です。CPU と GPU 間の 900 GB/秒 NVLink(R)- C2C 接続により、Grace Hopper は PCIe Gen 5 と比較して 7 倍高速なデータ転送とクエリが提供可能です。

プラットフォームのソフトウェア レイヤーは、NVIDIA TensorRT™ ( https://developer.nvidia.com/tensorrt ) (高性能ディープラーニング推論用ソフトウェア開発キット) と NVIDIA Triton Inference Server™ ( https://developer.nvidia.com/nvidia-triton-inference-server ) (モデル展開の標準化を支援するオープンソースの推論サービス ソフトウェア) を含む NVIDIA AI Enterprise ソフトウェア スイート ( https://www.nvidia.com/ja-jp/data-center/products/ai-enterprise/ ) を備えています。

早期導入とサポート

Google Cloud は主要なクラウド パートナーであり、NVIDIA の推論プラットフォームの初期の顧客です。同社は L4 プラットフォームを機械学習プラットフォームである Vertex AI に統合しており、L4 インスタンスを提供する最初のクラウド サービス プロバイダーであり、G2 仮想マシンのプライベート プレビューが本日開始されました。

NVIDIA と Google は本日、Google Cloud 上の L4 に早期アクセスできる最初の企業のうちの 2 社をそれぞれ発表しました。ジェネレーティブ AI を使用してクリエイターがビデオやポッドキャストを制作するのを支援する Descript と、Dream と呼ばれる AI を利用したテキストをデジタル アートに変換するアプリを提供する WOMBO です。

もう 1 社のアーリー アダプターである Kuaishou は、GPU を活用して着信ライブ ストリーミング ビデオのデコード、キー フレームのキャプチャ、オーディオとビデオの最適化を行う短いビデオ アプリを提供しています。同社は次に、Transformer ベースの大規模モデルを使用して、マルチモーダル コンテンツを理解し、世界中の何億人ものユーザーのクリック率を改善します。

「Kuaishou レコメンダー システムは、毎日 3,000 万の UGC ビデオに貢献する 3 億 6,000 万人を超えるユーザーがいるコミュニティにサービスを提供しています」と語るのは、Kuaishou のシニア バイス プレジデント、Yue Yu 氏です。「総所有コストが同じ場合の CPU と比較して、NVIDIA GPU はシステムのエンドツーエンドのスループットを 11 倍向上させ、レイテンシを 20% 削減します」

主要なジェネレーティブ AI テクノロジ プラットフォームである D-ID は、NVIDIA L40 GPU を使用してテキストからフォトリアルなデジタル ヒューマンを生成することで、プロフェッショナル向けのビデオ コンテンツを向上させます。これにより、あらゆるコンテンツに顔を与えながら、大規模なビデオ制作のコストと手間を削減します。

「L40 のパフォーマンスは驚くべきものでした。これにより、推論速度を 2 倍にすることができました」と、D-ID の研究開発担当バイス プレジデントである Or Gorodissky 氏は述べています。「D-ID は、コンピューティング コストを削減しながら、前例のないパフォーマンスと解像度で AI ヒューマンのリアルタイム ストリーミングを可能にする当社のオファリングの一部として、この新しいハードウェアを使用できることを喜ばしく思います」

業界をリードする AI 制作スタジオである Seyhan Lee は、ジェネレーティブ AI を使用して、映画、放送、エンターテイメント業界向けの没入型体験と魅力的なクリエイティブ コンテンツを開発しています。

「L40 GPU は、ジェネレーティブ AI アプリケーションのパフォーマンスを大幅に向上させます」と語るのは、Seyhan Lee の共同設立者である Pinar Demirdag 氏です。「L40 の推論機能とメモリ サイズにより、我々は最先端のモデルを展開し、信じられないほどの速度と精度で顧客に革新的なサービスを提供できます」

言語 AI のパイオニアである Cohere は、開発者がデータのプライバシーと安全性を維持しながら自然言語モデルを構築できるようにするプラットフォームを運営しています。

「NVIDIA の新しい高性能な H100 推論プラットフォームにより、対話型 AI、多言語エンタープライズ検索、情報抽出などのさまざまな NLP アプリケーションを強化する最先端の生成モデルを使用して、より優れた効率的なサービスをお客様に提供できるようになります」と、Cohere の CEO である Aidan Gomez 氏は述べています。

提供予定

NVIDIA L4 GPU は、Google Cloud Platform のプライベート プレビューで利用可能であり、Advantech、ASUS、Atos、Cisco、Dell Technologies、富士通、GIGABYTE、Hewlett Packard Enterprise、Lenovo、QCT そして Supermicro など、30 以上のコンピューター メーカーのグローバル ネットワークから提供されます。

NVIDIA L40 GPU は現在、ASUS、Dell Technologies、GIGABYTE、Lenovo、Supermicro などの主要なシステム ビルダーから入手でき、パートナー プラットフォームの数は年間を通じて拡大する予定です。

Grace Hopper Superchip は現在サンプル提供中であり、H100 NVL GPU 同様、今年後半に量産が予定されています。

NVIDIA AI Enterprise は現在、主要なクラウド マーケットプレイス、および数十のシステム プロバイダーやパートナーから入手可能です。NVIDIA AI Enterprise ( https://www.nvidia.com/ja-jp/data-center/products/ai-enterprise/ ) を利用する企業には、NVIDIA Triton Inference Server™、TensorRT™、および 50 を超える事前トレーニング済みのモデルとフレームワークについて、NVIDIA エンタープライズ サポート、定期的なセキュリティ レビュー、および 安定した API が提供されます。

ジェネレーティブ AI 向けの NVIDIA 推論プラットフォームを試すためのハンズオン ラボは、NVIDIA LaunchPad ( https://www.nvidia.com/ja-jp/data-center/launchpad/ )ですぐに無料で利用できます。 サンプル ラボには、サポート チャットボットのトレーニングと展開、エンド ツー エンドの AI ワークロードの展開、H100 での言語モデルの調整と展開、NVIDIA Triton を使用した不正検出モデルの展開が含まれます。

NVIDIA について

1993 年の設立以来、NVIDIA (NASDAQ: NVDA) はアクセラレーテッド コンピューティングのパイオニアです。同社が 1999 年に発明した GPU は、PC ゲーム市場の成長を促進し、コンピューター グラフィックスを再定義して、現代の AI の時代に火をつけながら、メタバースの創造を後押ししています。NVIDIA は現在、業界を再形成しているデータセンター規模の製品を提供するフルスタック コンピューティング企業です。詳細については、https://nvidianews.nvidia.com/ を参照してください。

企業プレスリリース詳細へ

PRTIMESトップへ

※ ニュースリリースに記載された製品の価格、仕様、サービス内容などは発表日現在のものです。その後予告なしに変更されることがありますので、あらかじめご了承下さい。