企業リリース Powered by PR TIMES

PR TIMESが提供するプレスリリースをそのまま掲載しています。内容に関する質問 は直接発表元にお問い合わせください。また、リリースの掲載については、PR TIMESまでお問い合わせください。

(2022/3/23)

カテゴリ:商品サービス

リリース発行企業:NVIDIA

新しい NVLink Switch System との組み合わせにより、それぞれの DGX SuperPOD が 1 エクサフロップスの AI 性能を発揮、新しい NVIDIA Eos スーパーコンピューターが世界最速の AI システムとなる見込み、拡大する DGX Foundry サービスが顧客の AI 開発を加速

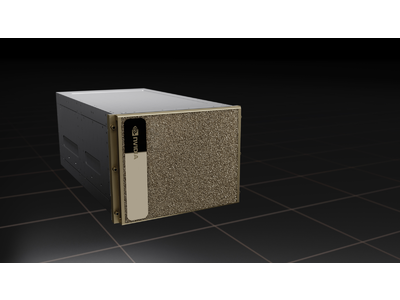

カリフォルニア州サンタクララ — GTC —2022 年 3 月 22 日 —NVIDIA は本日、新しい NVIDIA H100 ( https://www.nvidia.com/en-us/data-center/h100 )Tensor コア GPU を搭載した世界初の AI プラットフォームとなる、第 4 世代の NVIDIA(R) DGX™ システムを発表しました。

DGX H100 ( https://www.nvidia.com/en-us/data-center/dgx-h100/ )システムは、大規模言語モデル、レコメンダー システム、ヘルスケア研究および気候科学に必要とされる、膨大な演算性能要件に対応できるスケールを備えています。1 台のシステムには8 基の NVIDIA H100 GPU が搭載され、これらの GPU が NVIDIA NVLink(R) で 1 つに接続されています。DGX H100 システムは1台あたり、新しい FP8 精度で前世代の 6 倍以上となる、32 ペタフロップスの AI 性能を発揮します。

DGX H100 システムは、次世代の NVIDIA DGX POD™( https://www.nvidia.com/ja-jp/data-center/dgx-pod/ ) および NVIDIA DGX SuperPOD™ ( https://www.nvidia.com/ja-jp/data-center/dgx-superpod/ )AI インフラストラクチャ プラットフォームの構成要素となっています。最新の DGX SuperPOD アーキテクチャには、合計 256 基の H100 GPU を搭載する最大 32 のノードを接続する、新しい NVIDIA NVLink Switch System( https://www.nvidia.com/ja-jp/data-center/nvlink/ )が実装されています。

FP8 で 1 エクサフロップスと前世代の 6 倍以上の AI 性能を発揮する、次世代の DGX SuperPOD は、数兆のパラメータを持つ膨大な LLM ワークロードを処理できる能力によって、AI の地平を切り開きます。

NVIDIA の創業者/CEO であるジェンスン フアン (Jensen Huang) は、次のように述べています。「AI は、ソフトウェアでできること、ならびにソフトウェアの作り方を根本から変化させてきました。業界に革命をもたらしている企業は、自社の AI インフラストラクチャの重要性を認識しています。NVIDIA の新しい DGX H100 システムは、エンタープライズ AI ファクトリーを実現させ、データをもっとも貴重なリソース、つまりインテリジェンスへと変容させます」

世界最速の AI スーパーコンピューター、NVIDIA Eos を発表

NVIDIA は画期的な新しい AI アーキテクチャによって、いち早く DGX SuperPOD を構築し、NVIDIA の研究者たちが気候科学、デジタル バイオロジー、ならびに未来の AI を進展させるのを支援します。

NVIDIA の「Eos」スーパーコンピューターは、4,608 基の DGX H100 GPU を搭載する 576 台の DGX H100 システムで構成されます。今年後半に運用が開始されると、世界最速の AI システムになると予想されています。

NVIDIA Eos は、18.4 エクサフロップスの AI 演算性能を発揮する予定で、これは現在世界最速のシステムである日本のスーパーコンピューター、富岳の 4 倍の速さの AI 処理能力となります。従来の科学コンピューティングに向けては、Eos は 275 ペタフロップスの性能を発揮すると予想されています。

Eos は NVIDIA だけでなく、OEM やクラウド パートナーによる先進的な AI インフラストラクチャの設計の基礎となるでしょう。

DGX H100 システム、DGX POD および DGX SuperPOD により、エンタープライズ AI を容易に拡張

DGX H100 システムは容易に拡張可能なため、企業による初期プロジェクトから多様な展開に至るまでの AI 需要に対応することができます。

合計 6,400 億のトランジスタを備えた 8 基の H100 GPU に加えて、それぞれの DGX H100 には、2 基の NVIDIA BlueField(R)-3 DPU( https://www.nvidia.com/ja-jp/networking/products/data-processing-unit/ )が搭載されており、先進のネットワーク、ストレージおよびセキュリティのサービスをオフロード、加速および分離します。

8 つの NVIDIA ConnectX(R)-7 Quantum-2 InfiniBand ネットワーク( https://www.nvidia.com/ja-jp/networking/quantum2/ ) アダプターは、毎秒 400 ギガビットのスループットでコンピューティングおよびストレージと接続されます。この速度は前世代のシステムの 2 倍となっています。また、第 4 世代 NVLink を NVSwitch™ と組み合わせることで、それぞれの DGX H100 システムのすべての GPU を毎秒 900 ギガビットで接続します。これは、前世代の 1.5 倍の速度です。

DGX H100 システムはデュアル x86 CPU を搭載し、NVIDIA のネットワーキングおよび NVIDIA パートナーのストレージと組み合わせることで、あらゆる規模の AI コンピューティングに対応可能な柔軟性を備えた DGX POD を実現します。

DGX SuperPOD により、企業は DGX H100 システムでスケーラブルな AI 研究拠点を構築できるようになります。DGX SuperPOD の DGX H100 ノードと H100 GPU は、NVLink Switch System と NVIDIA Quantum-2 InfiniBand にて接続され、合計 70 テラバイト/秒の帯域幅を実現します。これは、前世代の 11 倍に相当します。NVIDIA パートナーのストレージはテストを受け、DGX SuperPOD の AI コンピューティングに求められる要件を満たしているという認証を受けています。

さらに、複数の DGX SuperPOD ユニットを組み合わせれば、自動車、ヘルスケア、製造、通信、小売りなどの業界で必要とされている、巨大なモデルを開発するための AI 性能を得ることができます。

NVIDIA DGX Foundry が、DGX SuperPOD でお客様の成功への道を加速

ホステッド開発ソリューションの NVIDIA DGX Foundry ( https://www.nvidia.com/ja-jp/data-center/dgx-foundry/ )は、DGX SuperPOD のお客様がシステム導入中に、先進のコンピューティング インフラストラクチャを直ちに利用できるように、世界中に拡大しています。新たに追加された北米、ヨーロッパおよびアジアの地域でも、リモートで DGX SuperPOD あるいはその一部を利用することができます。

DGX Foundry には NVIDIA Base Command™ が含まれており、これによって、お客様は DGX SuperPOD インフラストラクチャ上で、エンドツーエンドの AI 開発ライフサイクルを簡単に管理することができます。

要件を満たす企業であれば、世界中の Equinix International Business Exchange™ (IBX(R)) データセンターでホストされている、NVIDIA LaunchPad ( https://www.nvidia.com/ja-jp/data-center/launchpad/ )のキュレーテッド ラボを通じて、NVIDIA Base Command と DGX システムを無料で体験することができます。

MLOps と Enterprise AI ソフトウェアが、増え続ける企業の AI 導入をサポート

AI 開発を運用する DGX のお客様をサポートするために、Domino Data Lab、Run:ai ( https://www.dominodatalab.com/news/domino-data-lab-extends-enterprise-mlops-to-the-edge-with-new-nvidia-fleet-command-support )および Weights & Biases といった NVIDIA DGX-Ready Software ( https://www.nvidia.com/ja-jp/data-center/dgx-ready-software/ )パートナーの MLOps ソリューションが、「NVIDIA AI Accelerated」プログラムに参加しています。

参加パートナーの MLOps アプリケーションは事前に検証され、エンタープライズ グレードのワークフローとクラスタの管理、スケジューリングおよびオーケストレーション ソリューションを DGX のお客様に提供できることが確認されます。

さらに現在、NVIDIA DGX システムには、ベアメタルのインフラストラクチャにも新しく対応する、NVIDIA AI Enterprise ( https://www.nvidia.com/en-us/data-center/products/ai-enterprise-suite/ )ソフトウェア スイートが実装されています。そのため、DGX のお客様は、NVIDIA RAPIDS™( https://www.nvidia.com/ja-jp/deep-learning-ai/software/rapids/ )、NVIDIA TAO Toolkit、NVIDIA Triton Inference Server™ ( https://developer.nvidia.com/nvidia-triton-inference-server )などのソフトウェア スイートに含まれている、トレーニング済みの NVIDIA AI プラットフォーム モデル、ツールキットおよびフレームワークによって、作業を加速させることができます。

DGX-Ready Managed Services プログラムにより、AI 導入を簡略化

企業の AI 導入が進む中、お客様は、ビジネスを変容させるために必要なインフラストラクチャを追加するための選択肢をさらに増やしたいと考えています。NVIDIA は、DGX-Ready Managed Services ( http://www.nvidia.com/en-us/data-center/dgx-ready-managed-services )プログラムを開始し、サービス プロバイダーに自社のインフラストラクチャを管理してもらうことを希望するお客様をサポートします。

Deloitte は、このプログラムで NVIDIA と連携する最初のグローバル プロバイダーで、地域のプロバイダーである Cgit、ePlus inc、Insight Enterprises ( https://solutions.insight.com/Resources/Press-and-News/2022/NVIDIA-DGX-Ready-Managed-Services-Program )および PTC System( https://ptcsys.com/services/dgxmsp/ )とともに、ヨーロッパ、北米およびアジアのお客様をサポートするための認証を受ける予定となっています。

Deloitte Consulting LLP のプリンシパル兼 AI およびデータ オペレーション機能担当リーダーであるジム ローワン (Jim Rowan) 氏は、次のように話しています。「AI によるビジネス ブレイクスルーの実現は、企業がその経営にテクノロジを統合することで初めて可能となります。新しい DGX-Ready Managed Services プログラムにより、お客様は、世界中にいる Deloitte のエキスパートが管理する、NVIDIA DGX システムとソフトウェアにより、世界最先端の AI を簡単に導入できるようになります」

DGX-Ready Lifecycle Management プログラムにより、アップグレードも簡単に

現在、新しい DGX-Ready Lifecycle Management( http://www.nvidia.com/en-us/data-center/dgx-lifecycle-management )プログラムを通じて、既存の DGX システムを最新の NVIDIA DGX プラットフォームにアップグレードすることが可能になっています。

DGX-Ready Lifecycle Management に参加している NVIDIA のチャネル パートナーは、前世代の DGX を更新して新しいお客様に購入いただけるようになり、世界共通の AI インフラストラクチャ用システムの利用を拡大します。

発売予定

NVIDIA DGX H100 システム、DGX POD および DGX SuperPOD は、第 3 四半期より、NVIDIA のグローバル パートナーを通じて入手いただけます。

お客様は、Cyxtera、Digital Realty および Equinix IBX データセンターなどの、NVIDIA DGX-Ready Data Center ( https://www.nvidia.com/ja-jp/data-center/colocation-partners/ )パートナーが運営するコロケーション施設に DGX を導入することもできます。

NVIDIA DGX システムについての詳細については、ジェンスン フアンのGTC 2022 基調講演( https://www.nvidia.com/ja-jp/gtc/keynote/ )のリプレイをご覧ください。 GTC 2022 に無料で登録し( https://www.nvidia.com/ja-jp/gtc/?ncid=ref-pr-242463 )、NVIDIA および業界のリーダーによるセッションに参加してください。

NVIDIA について

1999 年における NVIDIA( https://www.nvidia.com/ja-jp/#source=pr/ ) (NASDAQ表示: NVDA) による GPU の発明は、PC ゲーミング市場の成長に爆発的な拍車をかけ、現代のコンピューター グラフィックス、ハイパフォーマンス コンピューティング、そして人工知能 (AI) を再定義しました。NVIDIA のアクセラレーテッド コンピューティングと AI における先駆的な取り組みは、輸送、ヘルスケア、製造業などの数兆ドル規模の産業を再構築し、その他のさまざまな産業の拡大も加速させています。

詳細は、こちらのリンクから: https://nvidianews.nvidia.com/

企業プレスリリース詳細へ

PRTIMESトップへ

※ ニュースリリースに記載された製品の価格、仕様、サービス内容などは発表日現在のものです。その後予告なしに変更されることがありますので、あらかじめご了承下さい。