企業リリース Powered by PR TIMES

PR TIMESが提供するプレスリリースをそのまま掲載しています。内容に関する質問 は直接発表元にお問い合わせください。また、リリースの掲載については、PR TIMESまでお問い合わせください。

(2022/9/23)

カテゴリ:商品サービス

リリース発行企業:NVIDIA

Dell Technologies、HPE、Lenovo、Supermicro など世界の大手コンピューター メーカーや、AWS、Google Cloud、Microsoft Azure、Oracle Cloud Infrastructure などのクラウド サービス プロバイダーが H100 ベースの製品を構築、来月以降入手可能に

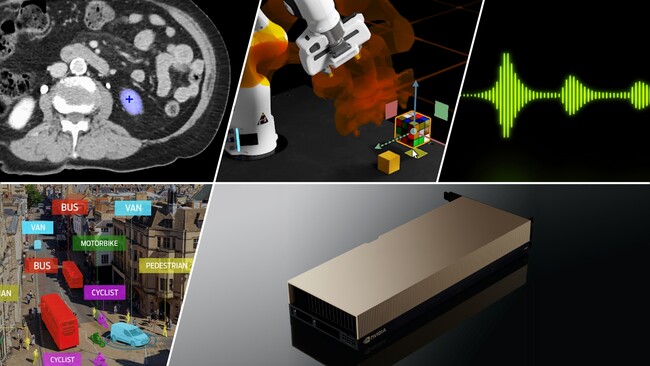

2022 年 9 月 20 日、カリフォルニア州サンタクララ — GTC— NVIDIA は本日、NVIDIA H100 Tensor コア GPU ( https://www.nvidia.com/ja-jp/data-center/h100/ ) の量産が開始しており、世界中のテクノロジ パートナーが 10 月に、画期的な NVIDIA Hopper™ アーキテクチャをベースとした製品およびサービスの第 1 弾を市場投入する予定であることを発表しました。

4 月に発表された H100 は、800 億のトランジスタを搭載し、さまざまな画期的テクノロジが導入されています。これらテクノロジの中には、パワフルな新しい Transformer Engine ( https://blogs.nvidia.co.jp/2022/04/07/h100-transformer-engine/ ) と NVIDIA NVLink(R) ( https://www.nvidia.com/ja-jp/data-center/nvlink/ ) インターコネクトが含まれており、先進のレコメンダー システムや大規模言語モデルといった最大規模の AI モデルを加速し、対話型 AI や創薬といった分野でイノベーションを主導します。

NVIDIA の創業者/CEO であるジェンスン フアン (Jensen Huang) は、次のように述べています。「Hopper は AI ファクトリーの新たなるエンジンです。膨大なデータを処理および洗練し、言語ベースの AI、ロボティクス、ヘルスケアおよびライフ サイエンスの発展に不可欠な、数兆のパラメータを備えたモデルのトレーニングを可能にします。Hopper の Transformer Engine は性能を桁違いのレベルにまで引き上げ、企業や研究者が大規模な AI および HPC を利用できるようにします」

Hopper のアーキテクチャおよび Transformer Engine 以外にも、H100 GPU には重要なイノベーション ( https://www.nvidia.com/ja-jp/technologies/hopper-architecture/ ) が複数実装されています。第 2 世代 Multi-Instance GPU、コンフィデンシャル コンピューティング、第 4 世代 NVIDIA NVLink および DPX 命令などを含むイノベーションが、NVIDIA のアクセラレーテッド コンピューティング データセンター プラットフォームのさらなる大きな飛躍を実現します。

メインストリーム サーバー用の H100 には、NVIDIA AI Enterprise ( https://www.nvidia.com/ja-jp/data-center/products/ai-enterprise/ ) ソフトウェア スイートの 5 年間ライセンスが含まれることになります。これにより、AI ワークフローの開発および展開が最適化され、組織は、AI チャットボット、レコメンダー エンジン、ビジョン AI などの構築に必要な AI のフレームワークやツールを利用できるようになります。

Hopper のグローバル展開

H100 により、企業は AI 導入のコストを削減し、同じ AI 性能を 3.5 倍のエネルギー効率で提供し、総費用を 3 分の 1 に削減できるようになるほか、前世代に比べてサーバー ノードを 5 分の 1 に削減することも可能となります。

この新しいテクノロジをすぐに試したいお客様のために、NVIDIA は無料のハンズオン ラボを提供する NVIDIA LaunchPad ( http://www.nvidia.com/en-us/launchpad/ai/tuning-and-deploying-a-language-model-on-h100/ ) 上で、H100 を搭載した Dell PowerEdge サーバーを提供し、企業が最新のハードウェアと NVIDIA AI ソフトウェアにアクセスできるようにしたことを発表しました。

また、お客様は、8 基の H100 GPU を搭載し、FP8 精度で 32 PFLOPSの性能を実現する NVIDIA DGX™ H100 システム ( https://www.nvidia.com/en-us/data-center/dgx-h100/ ) を注文することもできます。すべての DGX システムでは、NVIDIA Base Command™ ( https://www.nvidia.com/ja-jp/data-center/base-command/ ) と NVIDIA AI Enterprise ソフトウェアを活用することができ、単一のノードから、大規模言語モデルや他の膨大なワークロードを対象とした先進的な AI 開発を可能にする NVIDIA DGX SuperPOD™ ( https://www.nvidia.com/ja-jp/data-center/dgx-superpod/ ) へと展開させることができます。

H100 を搭載したシステムは世界の主要なコンピューター メーカーより、今後数週間のうちに出荷され、年末までには 50 種類以上のサーバー モデル、2023 年の前半にはさらに数十種類のサーバー モデルが市場に導入される予定です。システムを構築するパートナーには、Atos、Cisco、Dell Technologies ( https://www.dell.com/en-us/blog/experience-ai-with-nvidia-h100-on-dell-servers/ ) 、富士通、GIGABYTE、Hewlett Packard Enterprise、Lenovo、そして Supermicro ( https://www.supermicro.com/en/pressreleases/supermicro-expands-its-nvidia-certified-server-portfolio-new-nvidia-h100-optimized ) が含まれます。

さらに、世界有数の高等教育機関や研究機関が、次世代スーパーコンピューターに H100 を導入予定です。これらの機関には、バルセロナ スーパーコンピューティング センター、ロス アラモス国立研究所、スイス国立スーパーコンピューティング センター (CSCS)、テキサス アドバンスド コンピューティング センターおよび筑波大学が含まれます。

H100 がクラウドに登場

また、来年より、他のサービス プロバイダーに先駆けて、Amazon Web Services、Google Cloud、Microsoft Azure および Oracle Cloud Infrastructure ( https://blogs.oracle.com/cloud-infrastructure/post/oracle-partners-with-nvidia-to-solve-the-largest-ai-and-nlp-models ) が、クラウドで H100 のベースのインスタンスを展開する予定です。

Azure AI Infrastructure のジェネラル マネージャーであるニディ シャペル (Nidhi Chappell) 氏は、次のように話しています。「Microsoft Azure 上の最新の H100 GPU で次世代の AI モデルが構築されることを楽しみにしています。Hopper アーキテクチャの進化と Azure AI スーパーコンピューティングへの投資によって、世界中の AI の開発を加速させることができるでしょう。」

Oracle Cloud Infrastructure (OCI) の製品管理担当バイス プレジデントである カラン バッタ (Karan Batta) 氏は、次のように話しています。「当社は、NVIDIA の最新の H100 GPU をお客様に提供し、お客様がもっとも要件の厳しい機械学習や HPC ワークロードを加速できるよう支援しています。また、NVIDIA の次世代の H100 GPU により、当社では、要求の多い社内のワークロードにも対応できるようになります。ヘルスケア、自動運転車、ロボティクスおよび IoT といった分野でのブレイクスルーにより、共通のお客様を支援できるようになります。」

NVIDIA によるソフトウェアのサポート

H100 の先進の Transformer Engine テクノロジにより、組織は大規模な言語モデルを高精度で、迅速に開発できるようになります。このようなモデルは規模を拡大しながら成長を続けると同時に、複雑さも増すため、数か月もかけてトレーニングを行う必要が生じる場合があります。

この課題に対処するために、NVIDIA NeMo Megatron ( https://developer.nvidia.com/nemo/megatron ) 、Microsoft DeepSpeed、Google JAX、PyTorch, TensorFlow および XLA といった、世界の主要な大規模言語モデルおよびディープラーニングのフレームワークには、H100 への最適化が行われています。これらのフレームワークを Hopper アーキテクチャと組み合わせることにより、AI 性能が飛躍的に向上し、数日または数時間で大規模言語モデルのトレーニングが可能になるでしょう。

NVIDIA Hopper および H100 についての詳細を知るためは、ジェンスン フアンによる GTC 2022 の基調講演 ( https://www.nvidia.com/ja-jp/gtc/keynote/ ) のリプレイをご視聴ください。GTC への無料登録 ( https://register.nvidia.com/flow/nvidia/gtcfall2022/attendeeportal/page/sessioncatalog ) により、NVIDIA および業界リーダーたちのセッションに参加することができます。

NVIDIA について

1993 年の創業以来、NVIDIA (NASDAQ: NVDA) は、アクセラレーテッド コンピューティングのパイオニアとして活動してきました。1999年の GPU の発明は、PC ゲーミング市場の成長に拍車をかけ、コンピュータ グラフィックスを再定義し、現在の AI 時代の火付け役となりました。NVIDIA は現在、データセンター規模の製品を提供するフルスタック コンピューティング企業であり、産業のあり方を大きく変えています。詳細は、こちらのリンクから:https://nvidianews.nvidia.com/

企業プレスリリース詳細へ

PRTIMESトップへ

※ ニュースリリースに記載された製品の価格、仕様、サービス内容などは発表日現在のものです。その後予告なしに変更されることがありますので、あらかじめご了承下さい。